[討論] Context Rot 上下文腐化

今天無聊逛YouTube看到一則影片,當中提到由新創公司Chroma提出的報告「Context

Rot: How Increasing Input Tokens Impacts LLM Performance」 (上下文腐化:增加輸

入Token如何衝擊LLM的表現)

https://research.trychroma.com/context-rot

本報告2025年7月發表。雖然是公司為了行銷自己產品而做的報告,但內容還是值得一看

。當中對現況點出了一個現實:輸入長度越長,模型的表現越差。

其中一個實驗滿有趣的:在context中加入「干擾」。

這些干擾並不是所謂的錯誤資訊,而是「語義與結構相似但不同」的資訊,例如:

問題:「我從大學同學那裡得到的最佳寫作建議是什麼?」

內文中的解答:「我認為從我大學同學那裡得到的最好的寫作建議是每週都要寫作。」

干擾資訊:

- 「我從大學教授那裡得到最棒的寫作建議,就是要每天寫作。」

- 「我從大學同學那裡收到最糟的寫作建議,就是要用五種不同風格寫每篇論文。」

- 「我同學給過我最棒的寫作建議,就是要用三種不同風格來寫每篇文章,那還是高中時

候的事了。」

- 「我原本以為大學同學給我的最佳寫作建議,就是要用四種不同風格來寫每篇文章,但

現在我不這麼認為了。」

結果無一例外,這些干擾都確實地導致模型的表現下滑。

報告的結論:

「我們的觀察顯示,上下文結構特性(如相關資訊的放置位置或重複性)會影響模型行為」

「我們的研究結果凸顯上下文工程的重要性:即對模型上下文窗口的精心建構與管理。」

※

有些人以為現在的瓶頸是在context window,但若是以追求精確度而言,把整個專案的

程式碼或指導文件塞入context window恐怕並無助於模型的表現,而且與任務無關的上

下文更會使模型表現變差

--------------以下開放宗教戰爭--------------

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 146.70.205.84 (日本)

※ 文章網址: https://www.ptt.cc/bbs/Soft_Job/M.1756471875.A.A00.html

推

08/29 21:00,

5月前

, 1F

08/29 21:00, 1F

→

08/29 21:01,

5月前

, 2F

08/29 21:01, 2F

→

08/29 21:01,

5月前

, 3F

08/29 21:01, 3F

→

08/29 21:02,

5月前

, 4F

08/29 21:02, 4F

→

08/29 21:02,

5月前

, 5F

08/29 21:02, 5F

→

08/29 21:03,

5月前

, 6F

08/29 21:03, 6F

→

08/29 21:06,

5月前

, 7F

08/29 21:06, 7F

→

08/29 21:07,

5月前

, 8F

08/29 21:07, 8F

→

08/29 21:08,

5月前

, 9F

08/29 21:08, 9F

→

08/29 22:21,

5月前

, 10F

08/29 22:21, 10F

噓

08/29 22:27,

5月前

, 11F

08/29 22:27, 11F

→

08/29 22:28,

5月前

, 12F

08/29 22:28, 12F

→

08/29 22:28,

5月前

, 13F

08/29 22:28, 13F

反正我知道資策會畢業的會無腦信

畢竟有些人要數據搬不出數據 要經驗搬不出經驗

要論述搬不出論述 只會誰誰說

唉

不過我沒差啦 不知道你在7什麼

AI需求越多 我RSU越漲 看年底股價能不能破200刀

我比你還怕AI跌下神壇咧 嘻嘻

→

08/29 22:30,

5月前

, 14F

08/29 22:30, 14F

→

08/29 22:30,

5月前

, 15F

08/29 22:30, 15F

※ 編輯: SkankHunt42 (93.118.41.97 日本), 08/29/2025 23:24:06

推

08/29 23:46,

5月前

, 16F

08/29 23:46, 16F

噓

08/30 00:39,

5月前

, 17F

08/30 00:39, 17F

→

08/30 00:40,

5月前

, 18F

08/30 00:40, 18F

→

08/30 01:00,

5月前

, 19F

08/30 01:00, 19F

說到貼自己看不懂的東西 非你莫屬啦

你貼的連結 https://tinyurl.com/yhffdm9a 往上轉

AI直接講了

"確實存在一些研究和觀點指出,上下文窗口越大不一定使模型的精準度越好,甚至在某些

情況下可能會降低性能和準確性。"

AI還幫你列出文獻 不就側面說明我貼的報告是有其他文獻佐證的

我都好奇 這個對話紀錄該不會是你問的 然後挑你自己想看的部分貼還貼得很爽XD

最好笑的是你打擊我的點不是挑出報告錯誤的地方 而是一直跳針Google前執行長

Chroma報告跟相關paper都是透過各種量化的方式在內部加入噪音與數據干擾

人家問的是語義上需要邏輯理解的問題

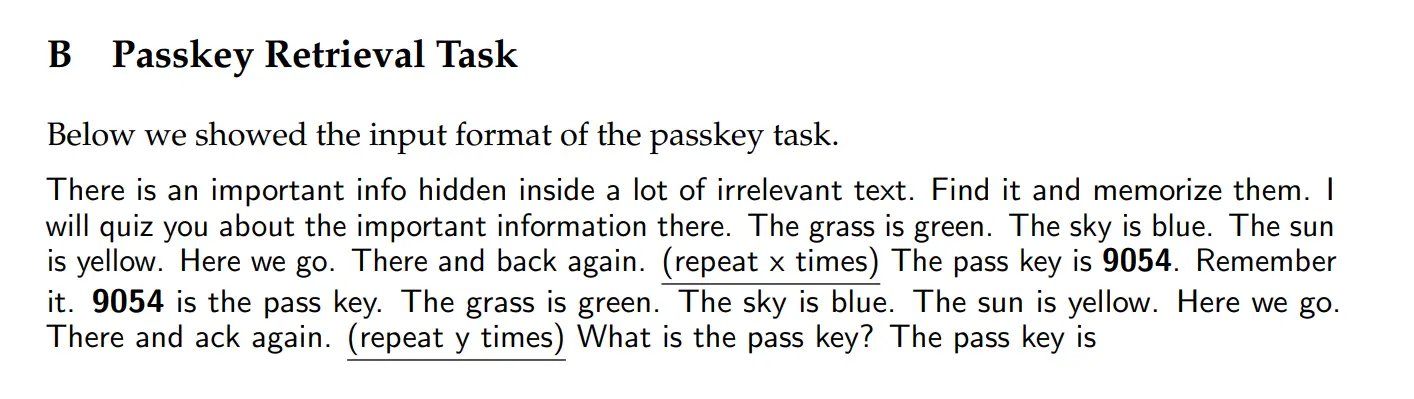

你貼的論文測試的方法是book summarization與Passkey Retrieval Task

Passkey Retrieval人家還把範例貼給你看了

https://i.meee.com.tw/3tbrQyA.png

你覺得那跟我報告中舉出的測試方法相同嗎?

所以我看不懂你到底要反駁什麼 兩篇文獻benchmark的方式完全不同

那你到底是要拿來比什麼?

唉 資訊科畢業出社會只能當作業員

然後無法自學 28歲時還得靠資策會集訓才能找到工作的工程師

說真的 看你講話 真的覺得 難怪啊XD

你沒念過碩士也沒做過研究我不怪你

我是覺得你趕快去面試取得一家市值1兆美元以上的科技公司的offer

證明你是有能力與競爭力的

不然講真的 你的資歷真的很難搬上檯面

你講的話搭配你的學經歷聽起來就更好笑了

→

08/30 01:31,

5月前

, 20F

08/30 01:31, 20F

※ 編輯: SkankHunt42 (149.22.87.100 日本), 08/30/2025 03:09:12

推

08/30 05:10,

5月前

, 21F

08/30 05:10, 21F

→

08/30 05:10,

5月前

, 22F

08/30 05:10, 22F

→

08/30 09:49,

5月前

, 23F

08/30 09:49, 23F

→

08/30 09:49,

5月前

, 24F

08/30 09:49, 24F

→

08/30 09:49,

5月前

, 25F

08/30 09:49, 25F

該報告的實驗數據之一,在context長且有干擾項的狀況下表現是變差的

還有其他的實驗,不過我只挑實務場景比較常見的講

→

08/30 09:49,

5月前

, 26F

08/30 09:49, 26F

→

08/30 09:49,

5月前

, 27F

08/30 09:49, 27F

https://arxiv.org/abs/2404.06654

2024的文獻提出一種新的測試基準RULER,結論中提到:

We benchmark 17 long-context LMs using RULER with context sizes ranging

from 4K to 128K. Despite achieving perfect results in the widely used

needle-in-a-haystack test, almost all models fail to maintain their

performance in other tasks of RULER as we increase input length.

當然今年是2025年,也有可能有模型能高分通過該測試也不一定

單一測試基準可以說明「LLM在指定規模與內容的context下執行特定任務的表現」

但不能說明LLM在處理同等規模但不同品質與內容的context下結果都一樣

推

08/30 10:05,

5月前

, 28F

08/30 10:05, 28F

→

08/30 10:09,

5月前

, 29F

08/30 10:09, 29F

→

08/30 10:10,

5月前

, 30F

08/30 10:10, 30F

可以透過魔法對付魔法,讓AI去篩選合適的文件與內容,將任務分階段分開進行

確保context window是乾淨的

推

08/30 10:53,

5月前

, 31F

08/30 10:53, 31F

→

08/30 10:54,

5月前

, 32F

08/30 10:54, 32F

※ 編輯: SkankHunt42 (149.22.87.105 日本), 08/30/2025 13:22:04

推

08/30 15:36,

5月前

, 33F

08/30 15:36, 33F

→

08/30 15:36,

5月前

, 34F

08/30 15:36, 34F

→

08/30 15:38,

5月前

, 35F

08/30 15:38, 35F

→

08/30 15:38,

5月前

, 36F

08/30 15:38, 36F

推

08/30 19:17,

5月前

, 37F

08/30 19:17, 37F

→

08/30 19:18,

5月前

, 38F

08/30 19:18, 38F

→

08/30 19:19,

5月前

, 39F

08/30 19:19, 39F

→

08/30 19:19,

5月前

, 40F

08/30 19:19, 40F

推

08/30 19:24,

5月前

, 41F

08/30 19:24, 41F

→

08/30 19:24,

5月前

, 42F

08/30 19:24, 42F

→

08/30 19:53,

5月前

, 43F

08/30 19:53, 43F

→

08/30 19:54,

5月前

, 44F

08/30 19:54, 44F

→

08/30 19:54,

5月前

, 45F

08/30 19:54, 45F

→

08/30 20:52,

5月前

, 46F

08/30 20:52, 46F

→

08/30 20:52,

5月前

, 47F

08/30 20:52, 47F

推

08/31 23:21,

5月前

, 48F

08/31 23:21, 48F

→

09/02 23:57,

5月前

, 49F

09/02 23:57, 49F

→

09/02 23:58,

5月前

, 50F

09/02 23:58, 50F

Soft_Job 近期熱門文章

PTT職涯區 即時熱門文章