[新聞] 中國智譜發布新開源模型 勝過Gemini3

原文標題:

GLM-5: From Vibe Coding to Agentic Engineering

原文連結:

https://z.ai/blog/glm-5

發布時間:

2026-02-12

記者署名:

無

※原文無記載者得留空

原文內容:

We are launching GLM-5, targeting complex systems engineering and long-horizon a

gentic tasks. Scaling is still one of the most important ways to improve the int

elligence efficiency of Artificial General Intelligence (AGI). Compared to GLM-4

.5, GLM-5 scales from 355B parameters (32B active) to 744B parameters (40B activ

e), and increases pre-training data from 23T to 28.5T tokens. GLM-5 also integra

tes DeepSeek Sparse Attention (DSA), significantly reducing deployment cost whil

e preserving long-context capacity.

我們正式推出 GLM-5,其目標是應對複雜系統工程與長時程智慧體任務。規模化仍然是提升

通用人工智慧智慧效率最重要的方法之一。與 GLM-4.5 相比,GLM-5 的規模從 3,550 億參

數(其中 320 億為啟動參數)擴展至 7,440 億參數(400 億啟動參數),並將預訓練數據

從 23T 提升至 28.5T Token。此外,GLM-5 整合了 DeepSeek 稀疏注意力機制,在大幅降

低部署成本的同時,仍保有優異的長文本處理能力。

Reinforcement learning aims to bridge the gap between competence and excellence

in pre-trained models. However, deploying it at scale for LLMs is a challenge du

e to RL training inefficiency. To this end, we developed slime, a novel asynchro

nous RL infrastructure that substantially improves training throughput and effic

iency, enabling more fine-grained post-training iterations. With advances in bot

h pre-training and post-training, GLM-5 delivers significant improvement compare

d to GLM-4.7 across a wide range of academic benchmarks and achieves best-in-cla

ss performance among all open-source models in the world on reasoning, coding, a

nd agentic tasks, closing the gap with frontier models.

強化學習旨在彌補預訓練模型在「勝任」與「卓越」之間的差距。然而,由於強化學習訓練

效率低下的問題,將其大規模應用於大型語言模型仍具挑戰性。為此,我們開發了「slime

」——一種新型的非同步強化學習基礎設施,能顯著提升訓練吞吐量與效率,從而實現更細

粒度的後訓練迭代。憑藉在預訓練與後訓練方面的進步,GLM-5 在各項學術基準測試中相較

於 GLM-4.7 有顯著提升,並在推理、程式碼編寫與智慧體任務方面,於全球所有開源模型

中達到了頂尖表現,進一步縮小了與前沿模型之間的差距。

心得/評論:

https://i.meee.com.tw/DAfKbgq.jpg

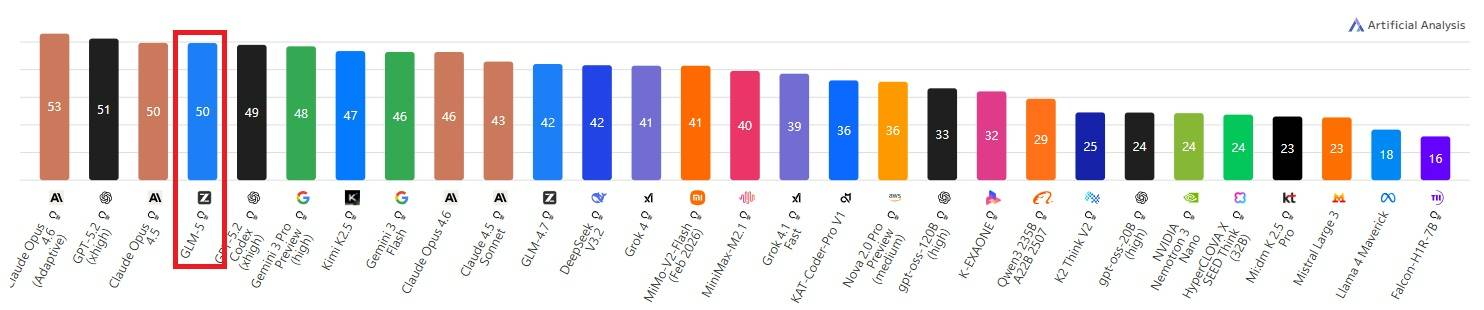

智譜 (2513.HK) 發布了新一代大模型 GLM-5,基準測試已超越 Google 的 Gemini 3 系列

,僅次於 Claude Opus 4.6 與 GPT-5.2 (深度思考模式)。

作為全球首個上市的純AI模型公司,上市後的第一個旗艦模型依舊維持MIT開源,任何人現

在都能下載直接用,這要怎麼賺錢?不過市場看起來很熱烈,早盤最高達到+33%了。

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 42.79.16.163 (臺灣)

※ 文章網址: https://www.ptt.cc/bbs/Stock/M.1770868985.A.244.html

Stock 近期熱門文章

PTT職涯區 即時熱門文章