Re: [新聞] OpenAI與硬體供應商Cerebras簽約

bull shit

https://tinyurl.com/4kjvpak2

Cerebras Systems 推出尺寸最大晶片,推理速度超過輝達 Blackwell

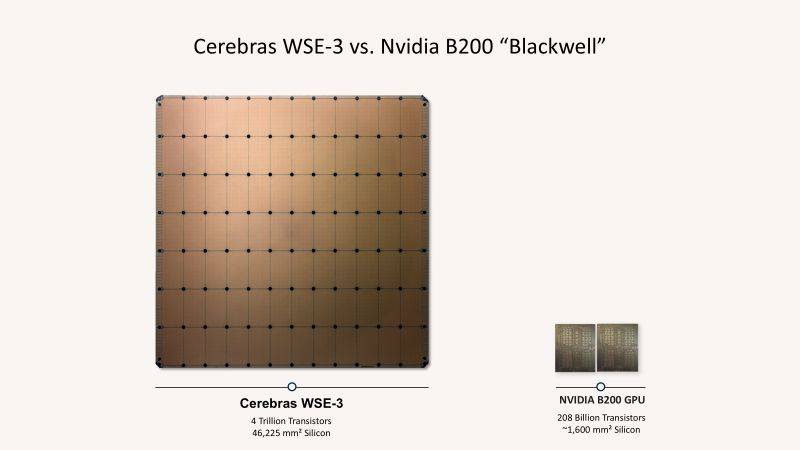

這款晶片的尺寸是 8.5 英吋(約 22 公分)的巨大方形晶片

一顆晶片比你的書桌還大張,

這是人類史上最大的晶片,

也是實用性與商業化最低的產品

一顆晶片大概是Rubin 的 8x8=64 10x10=100 倍大小,

良率(壞掉機率)跟面積成正比,

所以這顆晶片的良率是一般GPU TPU的1% - 0.1%,

也就是說,

如果一片晶圓wafer 能產出99%良率的GPU TPU,

Cerebras 這顆晶片的良率大概1%,

如果GPU生產一百萬顆晶片的成本,

大概是Cerebras 生產一萬顆到一千顆晶片的成本

用白話文說,

Cerebras 用大力出奇蹟的方式,

用土豪硬堆最貴的料 最高的成本,

硬堆出來的效能,

只能在PPT上面吹,

完全沒有實用性與商業性

這個其實是業界都知道的事情,

這新聞單純是OpenAI 炒新聞吵估值用的,

事實是根本無法用,

也無法大規模使用,

所以OpenAI 也就不用花錢

https://tinyurl.com/2a323ane

另外,

Sam Altman既是客戶也是金主,

OpenAI執行長Sam Altman本人就是Cerebras的個人投資者

Cerebras估值翻倍,OpenAI尋求「非NVIDIA」解決方案

受此大單激勵,Cerebras正在洽談一筆10億美元的融資

※ 引述《h0103661 (單推人) 每日換婆 (1/1)》之銘言:

: 原文標題:

: OpenAI partners with Cerebras

:

: 原文連結:

: https://openai.com/index/cerebras-partnership/

:

: 發布時間:

: 2026-01-14

:

: 記者署名:

: ※原文無記載者得留空

:

: 原文內容:

: Cerebras builds purpose-built AI systems to accelerate long outputs from AI mode

: ls. Its unique speed comes from putting massive compute, memory, and bandwidth t

: ogether on a single giant chip and eliminating the bottlenecks that slow inferen

: ce on conventional hardware.

: Cerebras 致力於打造專為加速 AI 模型長文本輸出而設計的專用系統。其獨特的速度優勢

: 源於將海量的運算能力、記憶體與頻寬整合至單一巨型晶片中,進而消除了傳統硬體中限制

: 推理速度的瓶頸。

: Integrating Cerebras into our mix of compute solutions is all about making our A

: I respond much faster. When you ask a hard question, generate code, create an im

: age, or run an AI agent, there is a loop happening behind the scenes: you send a

: request, the model thinks, and it sends something back. When AI responds in rea

: l time, users do more with it, stay longer, and run higher-value workloads.

: We will integrate this low-latency capacity into our inference stack in phases,

: expanding across workloads.

: 將 Cerebras 納入我們的運算解決方案組合,核心目標是顯著提升 AI 的響應速度。無論是

: 提出複雜問題、生成程式碼、創建影像或運行 AI Agents,幕後都存在一個循環:用戶發

: 送請求、模型進行思考、系統回傳結果。當 AI 能實現即時響應時,使用者將能進行更多操

: 作、增加留存時間,並執行更高價值的運算任務。

: 我們將分階段把這種低延遲能力整合到我們的推理中,並逐步擴展至各類工作負載。

: “OpenAI’s compute strategy is to build a resilient portfolio that matches the

: right systems to the right workloads. Cerebras adds a dedicated low-latency infe

: rence solution to our platform. That means faster responses, more natural intera

: ctions, and a stronger foundation to scale real-time AI to many more people,” s

: aid Sachin Katti of OpenAI.

: OpenAI 的 Sachin Katti 表示:「OpenAI 的運算策略是建立一個具韌性的資源組合,將最

: 適配的系統應用於相應的工作負載。Cerebras 為我們的平台增添了專用的低延遲推理方案

: 。這意味著更快的響應、更自然的互動,並為向更多大眾普及即時 AI 奠定了更堅實的基礎

: 。」

: “We are delighted to partner with OpenAI, bringing the world’s leading AI mode

: ls to the world’s fastest AI processor. Just as broadband transformed the inter

: net, real-time inference will transform AI, enabling entirely new ways to build

: and interact with AI models,” said Andrew Feldman, co-founder and CEO of Cerebr

: as.

: Cerebras 共同創辦人兼執行長 Andrew Feldman 則表示:「我們非常榮幸能與 OpenAI 合

: 作,將世界領先的 AI 模型帶到全球最快的 AI 處理器上。正如寬頻改變了網際網路,即時

: 推理也將變革 AI,開啟構建 AI 模型及與其互動的全新方式。」

: The capacity will come online in multiple tranches through 2028.

: 相關產能將在 2028 年前分多個批次陸續上線。

:

:

: 心得/評論:

: https://i.meee.com.tw/FhiaPws.png

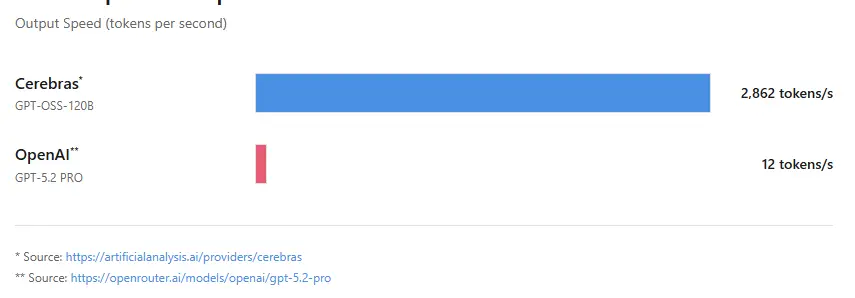

: Cerebras提供世界唯一的晶圓運算,模型推論速度輾壓GPU,數據比較:

: Cerebras: 2862 tokens/s

: OpenAI: 12 tokens/s

: https://i.meee.com.tw/qvzhS0b.jpg

: Cerebras使用的WSE3晶圓引擎是完全由台積電5奈米製作,

: 等於TSMC間接獲得了OpenAI的三年大單,

: 不找老黃了,但贏家一樣是台積電。

:

:

:

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 76.103.225.6 (美國)

※ 文章網址: https://www.ptt.cc/bbs/Stock/M.1769589988.A.C87.html

討論串 (同標題文章)

完整討論串 (本文為第 2 之 2 篇):

Stock 近期熱門文章

PTT職涯區 即時熱門文章