Re: [討論] 大家會擔心 ai 寫 code 讓工程師飯碗不

看板Soft_Job (軟體人)作者DrTech (竹科管理處網軍研發人員)時間1年前 (2024/11/03 16:09)推噓15(15推 0噓 62→)留言77則, 20人參與討論串7/8 (看更多)

※ 引述《angus850503 (安格斯)》之銘言:

: 借版問

: 小弟目前為前端工程師 受益於 Copilot 跟 ChatGPT

: 開發上真的輕鬆非常非常多 已經把按 tab 當作開發的一環了XD

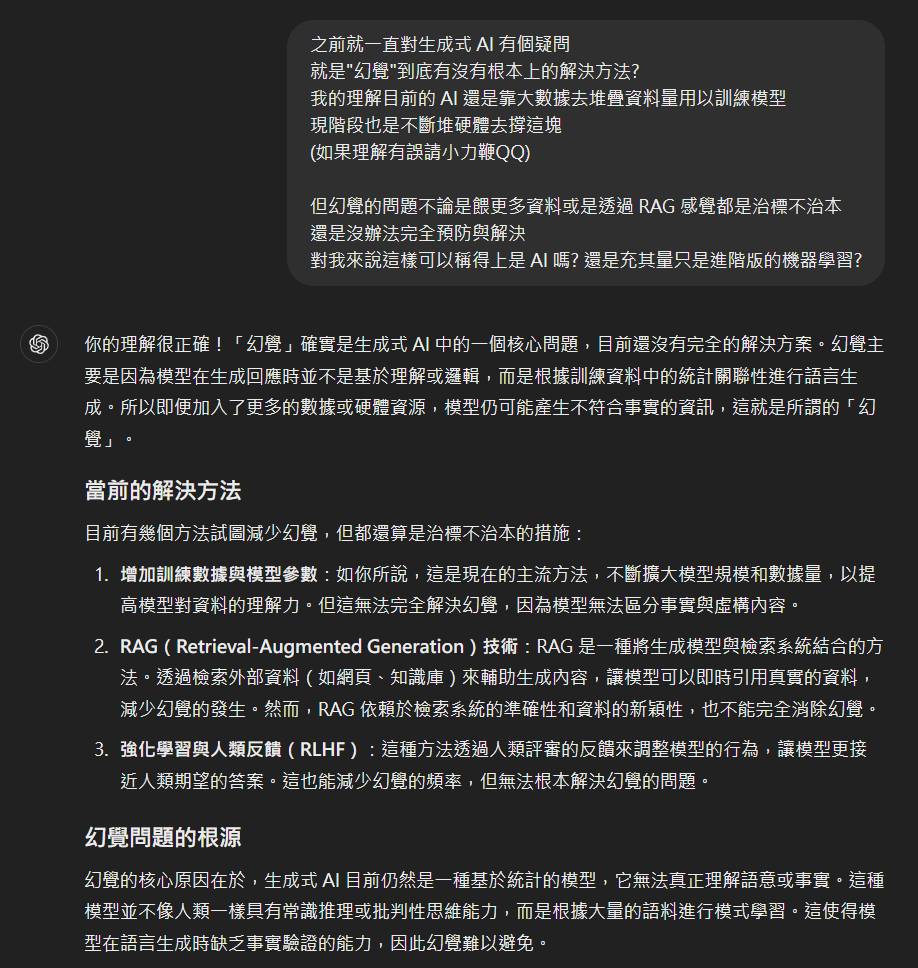

: 不過之前就一直對生成式 AI 有個疑問

: 就是"幻覺"到底有沒有根本上的解決方法?

: 我的理解目前的 AI 還是靠大數據去堆疊資料量用以訓練模型

: 現階段也是不斷堆硬體去撐這塊

: (如果理解有誤請小力鞭QQ)

: 但幻覺的問題不論是餵更多資料或是透過 RAG 感覺都是治標不治本

: 還是沒辦法完全預防與解決

: 對我來說這樣可以稱得上是 AI 嗎? 還是充其量只是進階版的機器學習?

: 請各位軟工大神解惑了QQ

: 附上這個議題 ChatGPT 自己的回答:

: https://i.meee.com.tw/Gk7IjRH.png

解決幻覺,不一定要從LLM解,

而是靠系統架構解。

例如,做一個問答系統,很多人減少幻覺是這樣做的:

0. 預先整理好QA問答資料集

(人工整理,或機器輔助整理)

1. 使用者輸入Query。

2. 搜尋top-k個相似的問題。

3. 將 k個最相似的問題與答案輸入至LLM,

要求LLM生成最適合的答案。

4. 將LLM生成的答案輸出。(可能有幻覺,可能沒幻覺,難以控制)

幾乎所有的網路上範例程式都告訴你這樣做。

這套系統架構稱為:LLM生成答案。

實際上,你只要改個系統架構,就可以得到完全沒幻覺,又同樣準確率又同樣等級的問答系統:

流程如下:

0. 整理QA資料集

1. 使用者輸入Query

2. 搜尋top-k相似的問題

3. 要求LLM在K個問題與答案,弄成K個選項

要求LLM選擇一個最適合的問題與答案。

LLM只輸出1, 2, 3, 4。

(如有必要,可用outlines 或 guidance,控制 next token 只做這四個選擇)

4. 根據LLM選擇的選項,

系統只輸出選項1,2,3,4 對應的答案A。

由於A不是LLM生成的,所以永遠不會有幻覺問題。

這套系統架構稱為:LLM選擇答案。(而不是生成答案)

也就是說,同樣一個系統,LLM原本是靠生成產生最後結果,轉換成LLM只能從多個沒幻覺的事實間,選擇一個事實。永遠不會有幻覺。

以上只是舉例。

任何一個AI功能,只要掌握一個訣竅,

LLM或AI的輸出結果,不要用在最後階段的輸出

而是轉化問題,系統設計成LLM用在中間某任務,在事實間做分類選擇,輸出的就永遠是事實。

根據實驗與經驗,答對答錯的機會也不會

因為改變了系統設計架構而有影響。

做AI應用,真的不是無腦套模型,套別人流程。

LLM也不是只能用在生成文字,傳統的,分類,選擇,NER,排序最佳化,…都可以靠LLM 做。

把LLM當成系統中間工具,而不是最終輸出,可以大幅提升AI能力,又完全不會產生幻覺。

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 42.72.189.178 (臺灣)

※ 文章網址: https://www.ptt.cc/bbs/Soft_Job/M.1730621342.A.166.html

→

11/03 16:33,

1年前

, 1F

11/03 16:33, 1F

→

11/03 16:44,

1年前

, 2F

11/03 16:44, 2F

→

11/03 16:44,

1年前

, 3F

11/03 16:44, 3F

→

11/03 16:44,

1年前

, 4F

11/03 16:44, 4F

→

11/03 16:50,

1年前

, 5F

11/03 16:50, 5F

→

11/03 16:50,

1年前

, 6F

11/03 16:50, 6F

推

11/03 18:40,

1年前

, 7F

11/03 18:40, 7F

推

11/03 20:57,

1年前

, 8F

11/03 20:57, 8F

→

11/03 20:58,

1年前

, 9F

11/03 20:58, 9F

→

11/03 21:04,

1年前

, 10F

11/03 21:04, 10F

推

11/03 23:26,

1年前

, 11F

11/03 23:26, 11F

→

11/03 23:38,

1年前

, 12F

11/03 23:38, 12F

→

11/03 23:38,

1年前

, 13F

11/03 23:38, 13F

→

11/03 23:38,

1年前

, 14F

11/03 23:38, 14F

→

11/03 23:38,

1年前

, 15F

11/03 23:38, 15F

→

11/03 23:38,

1年前

, 16F

11/03 23:38, 16F

→

11/03 23:38,

1年前

, 17F

11/03 23:38, 17F

→

11/03 23:38,

1年前

, 18F

11/03 23:38, 18F

→

11/03 23:44,

1年前

, 19F

11/03 23:44, 19F

→

11/03 23:44,

1年前

, 20F

11/03 23:44, 20F

→

11/03 23:44,

1年前

, 21F

11/03 23:44, 21F

推

11/04 00:44,

1年前

, 22F

11/04 00:44, 22F

→

11/04 06:54,

1年前

, 23F

11/04 06:54, 23F

→

11/04 06:54,

1年前

, 24F

11/04 06:54, 24F

→

11/04 07:15,

1年前

, 25F

11/04 07:15, 25F

→

11/04 07:15,

1年前

, 26F

11/04 07:15, 26F

→

11/04 07:15,

1年前

, 27F

11/04 07:15, 27F

→

11/04 07:15,

1年前

, 28F

11/04 07:15, 28F

→

11/04 07:17,

1年前

, 29F

11/04 07:17, 29F

→

11/04 07:17,

1年前

, 30F

11/04 07:17, 30F

→

11/04 08:11,

1年前

, 31F

11/04 08:11, 31F

→

11/04 08:16,

1年前

, 32F

11/04 08:16, 32F

→

11/04 08:16,

1年前

, 33F

11/04 08:16, 33F

→

11/04 08:18,

1年前

, 34F

11/04 08:18, 34F

→

11/04 08:28,

1年前

, 35F

11/04 08:28, 35F

→

11/04 08:28,

1年前

, 36F

11/04 08:28, 36F

→

11/04 21:00,

1年前

, 37F

11/04 21:00, 37F

推

11/04 23:20,

1年前

, 38F

11/04 23:20, 38F

→

11/05 07:34,

1年前

, 39F

11/05 07:34, 39F

→

11/05 07:34,

1年前

, 40F

11/05 07:34, 40F

→

11/05 07:34,

1年前

, 41F

11/05 07:34, 41F

→

11/05 07:37,

1年前

, 42F

11/05 07:37, 42F

→

11/05 07:38,

1年前

, 43F

11/05 07:38, 43F

→

11/05 07:41,

1年前

, 44F

11/05 07:41, 44F

→

11/05 07:41,

1年前

, 45F

11/05 07:41, 45F

→

11/05 07:41,

1年前

, 46F

11/05 07:41, 46F

→

11/05 07:46,

1年前

, 47F

11/05 07:46, 47F

→

11/05 07:46,

1年前

, 48F

11/05 07:46, 48F

→

11/05 07:46,

1年前

, 49F

11/05 07:46, 49F

→

11/05 09:26,

1年前

, 50F

11/05 09:26, 50F

推

11/05 09:44,

1年前

, 51F

11/05 09:44, 51F

→

11/05 09:44,

1年前

, 52F

11/05 09:44, 52F

→

11/05 09:44,

1年前

, 53F

11/05 09:44, 53F

→

11/05 10:21,

1年前

, 54F

11/05 10:21, 54F

→

11/05 10:21,

1年前

, 55F

11/05 10:21, 55F

→

11/05 10:21,

1年前

, 56F

11/05 10:21, 56F

→

11/05 10:22,

1年前

, 57F

11/05 10:22, 57F

→

11/05 10:28,

1年前

, 58F

11/05 10:28, 58F

→

11/05 10:28,

1年前

, 59F

11/05 10:28, 59F

→

11/05 10:28,

1年前

, 60F

11/05 10:28, 60F

推

11/05 11:45,

1年前

, 61F

11/05 11:45, 61F

→

11/05 11:45,

1年前

, 62F

11/05 11:45, 62F

→

11/05 11:45,

1年前

, 63F

11/05 11:45, 63F

→

11/05 11:46,

1年前

, 64F

11/05 11:46, 64F

→

11/05 12:35,

1年前

, 65F

11/05 12:35, 65F

推

11/05 13:28,

1年前

, 66F

11/05 13:28, 66F

推

11/06 00:14,

1年前

, 67F

11/06 00:14, 67F

推

11/06 11:30,

1年前

, 68F

11/06 11:30, 68F

→

11/06 11:30,

1年前

, 69F

11/06 11:30, 69F

推

11/07 14:31,

1年前

, 70F

11/07 14:31, 70F

→

11/08 12:26,

1年前

, 71F

11/08 12:26, 71F

→

11/08 17:19,

1年前

, 72F

11/08 17:19, 72F

推

11/09 13:09,

1年前

, 73F

11/09 13:09, 73F

→

11/09 13:10,

1年前

, 74F

11/09 13:10, 74F

推

11/10 13:30,

1年前

, 75F

11/10 13:30, 75F

推

11/10 20:01,

1年前

, 76F

11/10 20:01, 76F

推

11/24 10:57,

1年前

, 77F

11/24 10:57, 77F

討論串 (同標題文章)

本文引述了以下文章的的內容:

完整討論串 (本文為第 7 之 8 篇):

Soft_Job 近期熱門文章

PTT職涯區 即時熱門文章